Dans l’univers du référencement en constante évolution, un aspect longtemps méconnu et pourtant déterminant demeure clé : le budget d’exploration ou « crawl budget » que Google consacre à un site web. Alors que beaucoup croyaient qu’un site regorgeant de millions de pages pouvait être pénalisé simplement par sa volumétrie, la réalité technique dévoilée récemment par Gary Illyes, expert de Google, fait évoluer cette croyance. Ce qui prime désormais, ce n’est pas le nombre de pages hébergées, mais la vitesse d’exécution de la base de données sous-jacente. Cette précision bouleverse les pratiques, surtout pour les grands sites dynamiques, amplifiant la nécessité de réévaluer les fondations techniques qui supportent les portails web. Entre enjeux d’optimisation, conseils techniques et conséquences pratiques, nous décryptons ce virage décisif qui place la performance des bases de données au cœur de la stratégie SEO en 2025.

Comment la rapidité des bases de données influence le budget d’exploration chez Google

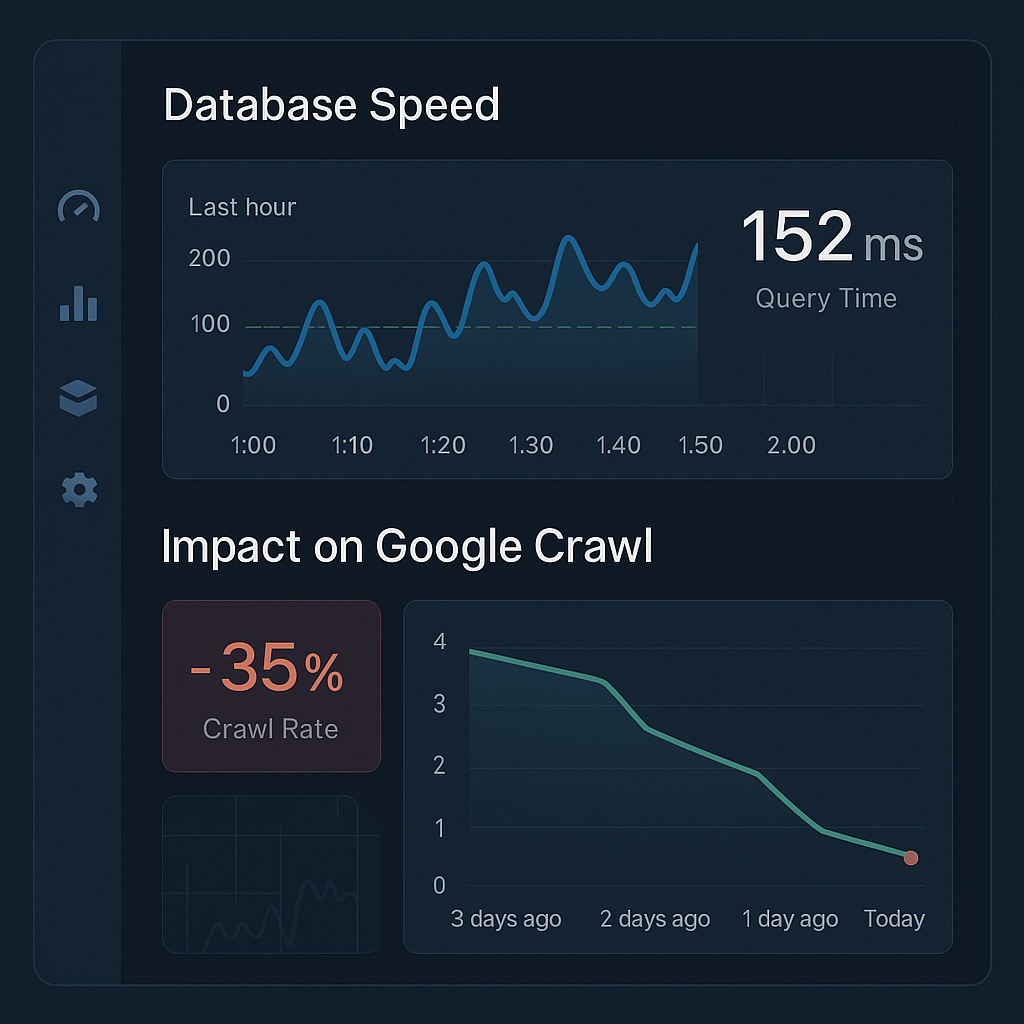

Depuis plusieurs années, les discussions autour du budget d’exploration par Google ont focalisé l’attention sur le volume de pages qu’un site possède. La croyance dominante était que les sites dépassant le seuil de 1 million de pages seraient automatiquement soumis à des limitations de crawl, ralentissant la découverte de nouvelles pages et impactant ainsi leur référencement. Or, dans un podcast récent, Gary Illyes, du Google Search Relations team, a clairement indiqué que le facteur primordial est en réalité la performance de la base de données qui sert ces pages, et non la simple quantité.

Cette déclaration signifie que la gestion technique des ressources serveurs est à présent le cœur du problème. Les requêtes longues ou complexes vers une base de données — qu’elle soit propulsée par des systèmes comme MongoDB, Cassandra ou encore Firebase — génèrent une surcharge qui ralentit les robots d’exploration. Google privilégiera donc la rapidité et l’efficacité des accès en base plutôt qu’une lecture brute du nombre de pages. Un site possédant 500 000 pages mais avec une base rapide pourra être beaucoup mieux exploré et indexé qu’un autre avec plusieurs millions de pages sur un système lent.

L’expertise de Google en gestion de données, appuyée par ses solutions comme Google Cloud, illustre parfaitement cette stratégie. L’accent est mis sur l’optimisation des temps de réponses des bases, couvrant aussi bien les SGBD traditionnels de Oracle ou IBM que les architectures modernes apportées par Elastic ou Snowflake.

- Les pages lourdes ou nécessitant un traitement dynamique intensif impactent plus la capacité d’exploration que le simple nombre de pages.

- Le curseur s’oriente vers une politique de crawl intelligente fondée sur la rapidité d’exécution des requêtes en base.

- Une base performante limite les coûts serveurs et favorise un crawl plus profond et régulier.

- Les sites dynamiques doivent prioriser l’optimisation de leur infrastructure backend.

En pratique, cette transformation invite à un audit technique approfondi des systèmes de gestion de données pour repérer les goulets d’étranglement. Elle amène aussi à rechercher des solutions améliorant la rapidité comme le caching intelligent, la réduction des requêtes onéreuses, et la mise en place de bases adaptées au traitement rapide des données.

| Critère | Impact sur Crawl Budget | Solutions recommandées |

|---|---|---|

| Nombre massif de pages (>1 million) | Peu d’impact direct sauf en cas de lenteur | Pas de changement si infra rapide |

| Requêtes base de données lentes | Fort impact nuisible au crawl | Optimisation, indexation, caching, requêtes plus légères |

| Contenu dynamique complexe | Accroît la charge serveur | Simplification, pré-génération de contenu |

Ce changement de paradigme est capital pour les acteurs du web souhaitant rester compétitifs en SEO. Il invite à dépasser la simple stratégie de contenu pour investir dans le cœur technique de délivrance des pages.

Le seuil d’un million de pages : mythe ou réalité toujours en vigueur en 2025 ?

Il est important de réexaminer la fameuse règle du million de pages souvent citée dans le domaine du référencement. Selon les déclarations officielles de Google, ce seuil demeure pertinent, mais avec une nuance importante : il s’agit plus d’une référence indicative que d’une barrière absolue. Elle figure comme un point d’ancrage historique remontant à une époque où le web et les technologies d’exploration étaient beaucoup moins avancés.

En effet, dans les années 1990, les systèmes comme WebCrawler exploraient environ 2 millions de pages, ce qui semblait colossal. Aujourd’hui, avec des dizaines de milliards de pages créées chaque jour, ce « million » paraît presque ridicule. Cependant, la robustesse des infrastructures, notamment celles soutenues par des géants comme Microsoft, Amazon et Google via leurs solutions cloud avancées, permet de maintenir ce seuil comme une règle pragmatique.

Cependant, la véritable raison pour laquelle Google n’a pas ajusté ce seuil tient à la complexité croissante des pages et à la multiplication des requêtes nécessaires à leur affichage. Une page dynamique générée avec Firebase ou un CMS gourmand en base peut consommer beaucoup plus de ressources, ce qui oblige Google à moduler le crawl en fonction des capacités serveur plutôt que du simple nombre de pages présentées.

La valeur « million de pages » reste donc un signal fort dans le paysage SEO, mais elle est désormais intégrée dans une approche plus fine et nuancée :

- Le seuil encourage les webmasters à surveiller la taille globale de leur site.

- Il avertit d’un potentiel plafonnement du crawl en cas d’infrastructures lente.

- Il ne faut pas s’enfermer dans ce chiffre, mais évaluer la qualité de l’infrastructure.

- Les ressources allouées par Google s’adaptent à la réalité matérielle technique.

Pour les très grands sites, la leçon est claire : la priorité est à l’optimisation des temps d’accès en base pour se prémunir des coupures dans l’exploration. Au-delà du million de pages, c’est la vitesse et l’agilité qui évitent que les robots n’abandonnent l’indexation.

| Année | Pages explorées par WebCrawler | État du Web |

|---|---|---|

| 1994 | 2 millions | Naissance du web, faible complexité |

| 2020 | Des milliards | Web dynamique, technologies JavaScript |

| 2025 (prévisions) | Trillions attendus | Réalité cloud, bases modernes et complexes |

Cette stagnation du chiffre de référence incite à relativiser les dogmes SEO et à préférer une compréhension orientée vers la qualité technique des plateformes web.

Pourquoi optimiser la performance des bases de données est plus crucial que le nombre de pages

Au cœur des révélations récentes se trouve un fait souvent ignoré : les bases de données lentes représentent un frein plus sérieux que le volume des pages pour la qualité du crawl. Cette problématique devient d’autant plus sensible avec l’essor des technologies d’indexation dynamique et des contenus personnalisés en temps réel.

Les structures de données sous-jacentes doivent assurer :

- Un traitement rapide des requêtes SQL ou NoSQL, notamment avec des technologies telles que Cassandra ou Elastic.

- Une gestion efficace des index et la minimisation des requêtes coûteuses.

- Une réponse fluide malgré la charge liée au trafic et à l’exploration simultanée par Googlebot.

Pour illustrer ce concept, prenons deux sites professionnels :

- Site A : 600 000 pages statiques hébergées sur une base optimisée utilisant Snowflake et un système de cache distribué.

- Site B : 200 000 pages dynamiques avec des requêtes lentes mais des pages massives générées par un CMS gourmand en base.

Dans un contexte d’exploration, Googlebot pourra plus aisément balayer rapidement le Site A car les pages se chargent rapidement avec une latence faible. À l’inverse, le Site B fera face à des coupures régulières car ses serveurs souffrent sous la charge, ralentissant ainsi la fréquence de crawl.

L’optimisation de la vitesse base de données passe par diverses démarches techniques :

- Audit des temps de réponse aux requêtes.

- Réduction du nombre de joins et traitements complexes inutiles.

- Mise en place d’index pertinents et actualisation régulière.

- Adoption de technologies NoSQL adaptées au type de données.

- Intégration de systèmes de cache efficace pour diminuer la charge.

| Problème | Conséquence sur crawl | Solution pratique |

|---|---|---|

| Requêtes SQL lourdes | Ralentissement du serveur | Optimisation des requêtes, dénormalisation |

| Base non-indexée | Temps de recherche augmenté | Création et maintenance d’index spécifiques |

| Pages dynamiques multiples | Charge serveur multiple | Mise en cache, pré-calcul des pages |

Cette approche invite également à aligner SEO et développement technique pour que la rapidité et la facilité d’indexation demeurent au cœur des process.

L’importance d’un bon crawl n’est plus une question de volume mais d’efficience technique

Le point de vue remis en avant par Gary Illyes souligne une vérité essentielle : ce n’est pas l’acte de crawling en lui-même qui consomme des ressources, mais bien l’indexation et la manière dont les données sont traitées après exploration. Cette nuance a des implications significatives pour la stratégie SEO et la gestion des serveurs.

En effet, bloquer Googlebot en pensant limiter la pression n’a pas toujours l’effet escompté. Il vaut mieux rendre l’expérience de crawling plus fluide en améliorant la transmission des données et en facilitant leur traitement. Cela implique :

- La simplification des structures de données.

- L’optimisation du code serveur côté backend.

- L’implémentation de formats clairs et standards favorisant le parsing rapide.

- L’anticipation des traitements en indexation pour limiter les erreurs.

Des entreprises comme IBM ou Oracle investissent massivement dans des bases de données intelligentes destinées à faciliter ces processus pour les grands comptes. À leur tour, les plateformes cloud proposent des outils qui optimisent cette chaîne, à l’image des solutions Google Cloud ou des alternatives proposées par Amazon.

| Action | Effet sur crawl | Avantage SEO |

|---|---|---|

| Réduction des traitements serveur post-crawl | Diminution des erreurs | Bon positionnement plus stable |

| Amélioration du temps de réponse | Augmentation du crawl potentiel | Meilleure couverture du site |

| Standardisation des données | Meilleur parsing | Moins d’ambiguïté pour Googlebot |

Au fond, l’enjeu réside dans la fluidité du processus complet, du crawl à l’indexation et à la restitution des données aux internautes.

Comment les grands acteurs du cloud et des bases de données influencent le crawl de sites massifs

Dans le contexte 2025, la gestion efficace des bases de données est largement orchestrée par des acteurs majeurs comme Google, Microsoft, Amazon, et des spécialistes en solutions de bases comme Elastic, Snowflake, ou MongoDB. Ces entreprises investissent en R&D pour proposer des architectures capables de traiter des volumes de données colossaux en temps réel, tout en assurant rapidité d’accès et faibles coûts.

Exemple : Google Cloud, salué par le Magic Quadrant du Gartner 2021 pour ses capacités, fournit des services d’hébergement et d’optimisation de bases adaptés aux exigences du crawl moderne. Ces plateformes garantissent :

- Une réplication rapide des bases pour la haute disponibilité.

- Un aiguillage intelligent des requêtes pour répartir la charge.

- Le support des bases NoSQL et SQL pour flexibilité.

- Des outils avancés de monitoring des performances.

Ces solutions aident les grandes entreprises à réduire le temps d’accès aux données, un facteur clé pour ne pas subir les restrictions de crawl imposées par défaut. Ainsi, un site très dense utilisant Elastic pour ses recherches en texte intégré, ou Cassandra pour la gestion de données massives, peut maintenir une performance optimale et garantir une indexation régulière.

| Acteur | Type de Base de Données | Avantage principal |

|---|---|---|

| Google Cloud | Bases relationnelles et NoSQL | Haute scalabilité et intégration IA |

| Amazon AWS | DynamoDB, Aurora | Performance et flexibilité cloud |

| Microsoft Azure | SQL Server, Cosmos DB | Sécurité et intégration globale |

| Elastic | Moteur de recherche distribué | Rapidité de recherche et analyse |

| MongoDB | NoSQL document | Adaptabilité aux données non structurées |

Le virage vers ces solutions influencera grandement la capacité des sites massifs à rester concurrentiels et bien crawlés. La synergie entre SEO et informatique cloud devient incontournable pour 2025.

Les stratégies d’optimisation SEO à adopter face à cette nouvelle réalité du crawl budget

Les directives Google renouvelées amènent à repenser les stratégies SEO, surtout pour les structures volumineuses. Pour optimiser la rapidité des bases, plusieurs axes peuvent être actionnés simultanément :

- Privilégier des caches puissants afin de minimiser les requêtes en base.

- Utiliser des bases adaptées aux types de données (relationnelles, NoSQL, etc.).

- Optimiser les requêtes pour accélérer leur exécution, en réduisant la complexité et la charge.

- Faire des audits réguliers sur les temps de réponse et les erreurs serveur.

- Miser sur une infrastructure cloud flexible pour faire face aux pics de charge.

Pour les sites de moins d’un million de pages, la recommandation reste la même : maintenir le contenu de qualité et l’expérience utilisateur avant tout. Pour les grands sites, en revanche, il devient indispensable de fusionner SEO et développement. Cette alliance se concrétise par des équipes pluridisciplinaires et une communication entre experts des bases de données et spécialistes du référencement.

Les outils d’audit spécialisés intégrant des indicateurs de base de données commenceront à se répandre dans les suites SEO. Ils permettront de mieux détecter les goulets d’étranglement techniques freinant le crawl. Par ailleurs, des services proposés par Google et les autres géants doivent être scrutés pour tirer parti de nouvelles fonctionnalités comme l’IA générative intégrée, favorisant une indexation plus rapide et intelligente.

| Objectif | Action recommandée | Impact attendu |

|---|---|---|

| Réduction du temps de réponse | Optimisation des requêtes et mise en cache | Plus de pages explorées par Googlebot |

| Meilleure gestion de la charge | Adoption de cloud scalable | Stabilité du crawl même en forte affluence |

| Facilitation de l’indexation | Amélioration du format et standardisation des contenus | Réduction des erreurs, gain en référencement |

Au-delà du technique pur, cette dynamique stimule aussi les innovations autour des bases de données, accélérant la démocratisation d’outils performants pour le marché SEO mondial.

L’évolution historique du crawl budget : perspective et comparaisons depuis les débuts du web

Pour bien saisir l’importance de la vitesse des bases de données, il est utile de replacer le concept de budget d’exploration dans son évolution historique. Au milieu des années 90, les moteurs comme WebCrawler ou Lycos fonctionnaient avec des ressources très limitées, et la notion même d’exploration était beaucoup plus simple et directe. Le crawl était d’abord limité par la capacité à parcourir des centaines de milliers à quelques millions de pages sans véritables contraintes technologiques complexes.

Avec l’arrivée du web 2.0, l’explosion des contenus générés dynamiquement et l’émergence massive de technologies telles que JavaScript, le défi est devenu très différent. Les robots doivent désormais exécuter des scripts, interroger des bases parfois complexes, et traiter des contenus souvent personnalisés. Cette complexité, si elle n’est pas bien maîtrisée, produit un effet boule de neige qui impacte sévèrement les capacités d’exploration.

Des entreprises comme IBM et Oracle, pionnières dans le domaine des bases de données, ont progressivement intégré ces nouvelles exigences dans leurs solutions cloud. Aujourd’hui, en 2025, cet héritage technique nourrit les avancées proposées par Google Cloud et les offres des autres géants technologiques.

- 1994-2000 : crawl faible volume, prioritisation des contenus essentiellement statiques.

- 2000-2015 : apparition des contenus dynamiques, première adaptation des robots.

- 2015-2025 : explosion des données, importance de la rapidité des bases et du traitement en temps réel.

| Période | Caractéristique principale | Conséquence SEO |

|---|---|---|

| 1994-2000 | Pages statiques majoritaires | Exploration rapide, simple |

| 2000-2015 | Développement du contenu dynamique | Besoin d’optimisation server |

| 2015-2025 | Web temps réel, complexité accrue | Vitesse base = facteur clé |

Comprendre cette évolution aide à anticiper les futures exigences et à adapter ses stratégies SEO de manière proactive.

Les implications pour les professionnels du SEO et les développeurs en 2025

À l’heure où l’interconnexion des équipes SEO et développeurs est plus que jamais nécessaire, la mise en lumière par Google de l’importance de la rapidité des bases de données impose un changement culturel profond. Les audits SEO incluent désormais une dimension technique sur la santé des bases de données, évaluant des indicateurs habituellement réservés aux DBA (administrateurs de bases de données).

Les professionnels du référencement doivent :

- Travailler en étroite collaboration avec les développeurs pour comprendre la structure des données et leur gestion.

- Intégrer les tests de performance des bases dans les processus d’optimisation SEO.

- Mettre en place des outils de monitoring des temps de réponse.

- Veiller à ce que les stratégies de contenus n’induisent pas une charge excessive sur les infrastructures.

De leur côté, les développeurs sont poussés à optimiser les requêtes, à introduire des solutions NoSQL ou hybrides selon les besoins, et à adopter des méthodes de cache, d’indexation et de pré-calcul qui allègent la charge serveurs. Cette collaboration est un vecteur majeur pour améliorer la qualité du crawl et garantir un référencement durable et performant.

| Rôle | Responsabilité vis-à-vis du crawl | Action clé recommandée |

|---|---|---|

| SEO | Analyse de la qualité crawl et contenu | Audit technique et collaboration avec dev |

| Développeur | Optimisation des bases et serveur | Mise en place d’architecture rapide et stable |

| DBA | Gestion des bases | Surveillance et tuning des performances |

Les formations doivent également évoluer pour intégrer ces nouvelles compétences, à l’image de ce que proposent les partenariats entre universités et acteurs comme Google (Google) ou Amazon.

Les tendances émergentes dans le domaine des bases de données et leur impact sur le crawl Google

En observant les tendances actuelles, on peut identifier plusieurs axes technologiques qui modifieront encore la manière dont Google attribue et utilise le crawl budget :

- Intelligence artificielle intégrée dans les bases afin d’anticiper les requêtes fréquentes et d’optimiser la restitution.

- Bases de données distribuées qui permettent une réplication rapide des données et résolvent les problèmes de latence géographique.

- Hybridation SQL/NoSQL pour allier structure et flexibilité, comme le propose Firebase.

- Cloud native : migration complète des bases vers des environnements cloud conçus pour une scalabilité automatique.

- Optimisation du streaming de données en temps réel poussée par les besoins en analytics et recommandations.

Ces innovations, menées par les leaders que sont Google, Microsoft, Amazon et spécialisés comme Elastic ou Snowflake, transformeront la capacité d’exploration des robots et la rapidité d’indexation. Il convient de suivre ces évolutions si l’on veut garder un avantage compétitif.

| Tendance | Description | Impact potentiel sur crawl |

|---|---|---|

| IA intégrée | Analyse prédictive des requêtes | Crawl ciblé et accéléré |

| Bases distribuées | Réduction de latence géographique | Crawl plus fluide à l’international |

| Hybridation SQL/NoSQL | Flexibilité et structure combinées | Meilleure adaptation du contenu |

| Cloud native | Scalabilité automatique | Gestion efficace des pics de crawl |

| Streaming temps réel | Données toujours fraîches | Indexation plus rapide |

Ce panorama invite à une veille technologique permanente et à intégrer ces éléments dans une stratégie SEO de pointe.

Lire plus sur l’impact de la vitesse base de données sur le crawl