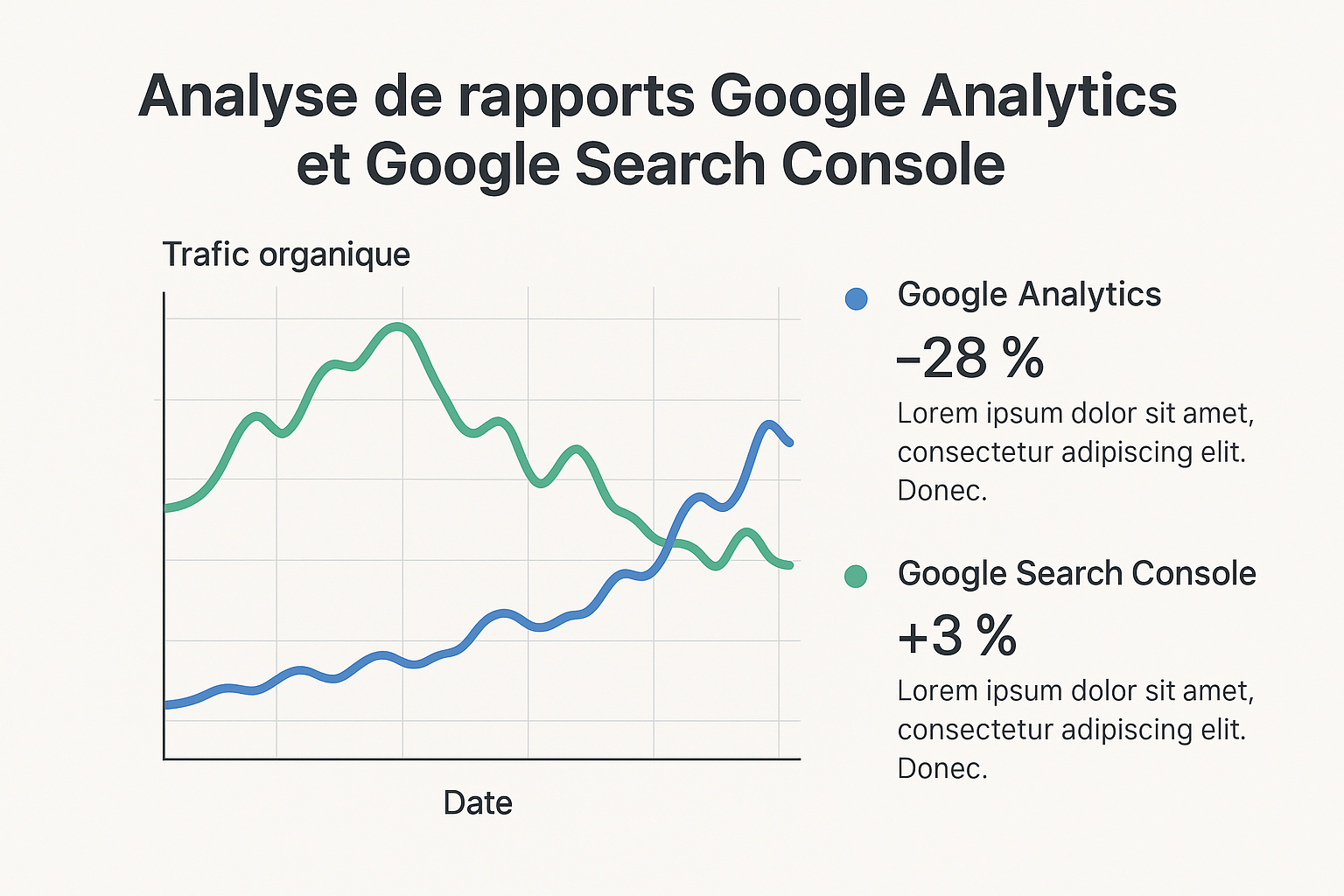

Dans l’univers complexe de l’analyse web, il n’est pas rare de constater des différences parfois déroutantes entre les données retransmises par Google Analytics (GA) et Google Search Console (GSC). Ces deux outils de référence, qu’utilisent quotidiennement des millions de professionnels du référencement, apportent pourtant une perception distincte du trafic organique d’un site. En 2025, alors que la maîtrise du trafic naturel est plus que jamais cruciale pour améliorer sa présence en ligne, il devient essentiel de comprendre à quoi répond chaque source de données. Pourquoi Google Analytics affiche-t-il souvent un nombre supérieur de visites organiques par rapport à Google Search Console ? Cette question soulève des enjeux techniques, méthodologiques et stratégiques, fondamentaux pour les spécialistes SEO et les analystes digitaux qui s’appuient sur des rapports fiables pour orienter leurs décisions. Explorons en profondeur les mécanismes qui sous-tendent ces écarts, les différences d’objectifs des deux plateformes, ainsi que les pièges à éviter pour interpréter au mieux les fluctuations des données de trafic organique.

Les fondamentaux de la mesure du trafic organique : différences entre Google Analytics et Google Search Console

Avant d’interpréter les divergences constatées, il convient de comprendre que Google Analytics et Google Search Console ont des fonctions et méthodologies différentes.

Google Analytics vise à mesurer les comportements des utilisateurs une fois qu’ils ont accédé à votre site web. Son principal objectif est de vous faire comprendre les interactions, les parcours et la qualité du trafic. Basé sur un système de cookies et de scripts JavaScript, GA collecte des données sur les sessions, les pages vues, les conversions, et offre des dimensions détaillées comme la source, le support, la campagne, grâce à des paramètres personnalisables.

En revanche, Google Search Console est un outil orienté vers l’analyse de la présence de votre site dans les résultats de recherche Google. Il repose sur les données côté serveur de Google, enregistrant les clics à partir des pages de résultats (SERP). Son périmètre se limite aux performances sur Google Search et ne capture pas les interactions post-clic ni le comportement utilisateur sur le site. GSC indique ainsi les mots-clés générateurs de trafic, les impressions, et les clics organiques mesurés directement depuis la plateforme de recherche.

Voici un tableau synthétique des différences clés :

| Critères | Google Analytics | Google Search Console |

|---|---|---|

| Type de données | Interactions utilisateur sur site (sessions, comportements) | Clics et impressions dans Google Search (SERP uniquement) |

| Sources de trafic incluses | Toutes (organique, paid search, direct, referral, social, etc.) | Uniquement trafic organique depuis Google Search |

| Métriques principales | Sessions, pages vues, utilisateurs | Clics, impressions, position moyenne |

| Mode de collecte des données | Tagging via JavaScript, cookies sur site | Données collectées côté moteur de recherche |

| Lien avec les autres sources | Peut combiner plusieurs propriétés, filtrage possible | Ne peut pas fusionner les données de domaines différents |

Cette distinction pose déjà les bases des écarts observés. Google Analytics capte un trafic organique plus large, incluant les visites venant d’autres moteurs de recherche comme Bing ou DuckDuckGo, tandis que Google Search Console ne rapporte que l’activité directement liée à Google Search. Ainsi, la notion de « trafic organique » diffère entre les deux outils.

- Ses sources de données différentes expliquent en partie les rigidités des chiffres observés.

- Les métriques ne sont pas équivalentes : sessions vs clics sont des univers à part.

- La configuration et le suivi technique peuvent aussi influer sur la précision et la répartition des données.

Pour affiner la compréhension, il est primordial de sonder les mécanismes sous-jacents à ces métriques et d’examiner l’impact des facteurs techniques tels que les cookies, le JavaScript, les bloqueurs et la gestion multi-domaine. Allons au cœur de ces détails essentiels.

Comment les différences de collecte des données influent sur les résultats : sessions versus clics

L’une des clefs pour saisir pourquoi GA affiche souvent un trafic organique supérieur à GSC réside dans la compréhension des mesures elles-mêmes, notamment la différence entre les « sessions » de Google Analytics et les « clics » de Google Search Console.

Une session dans Google Analytics est un groupement d’interactions d’un utilisateur avec votre site durant une période donnée. Lorsqu’un internaute ouvre une page et interagit, sa session démarre. Par défaut, cette session dure 30 minutes, mais peut être prolongée par de nouvelles activités sur le site.

En contraste, un clic dans Google Search Console est un événement unique enregistré dans les pages de résultats Google dès que l’utilisateur clique sur un lien vers votre site. Cet acte ne donne aucune information sur le temps passé, ni sur ce que l’utilisateur fait une fois sur votre page.

- Plusieurs clics peuvent conduire à une seule session si l’utilisateur navigue rapidement entre plusieurs résultats avant d’arriver sur votre site.

- Une séance dans GA peut inclure plusieurs pages vues, augmentant ainsi le volume d’interactions mesurées.

- Une session peut être divisée en plusieurs si l’utilisateur reste inactif plus de 30 minutes, ce qui crée des sessions supplémentaires non comptabilisées comme clics séparés dans GSC.

Ces différences signifient ainsi que les sessions dans Google Analytics peuvent être plus nombreuses que les clics dans Google Search Console pour une même page vue dans la SERP.

Exemple concret : un utilisateur clique sur votre lien dans une recherche Google (1 clic dans GSC), arrive sur votre page d’accueil, passe 20 minutes à consulter plusieurs pages (1 session dans GA, mais plusieurs pages vues). Une heure plus tard, il revient sur votre site via un bookmark (une nouvelle session GA) sans passer par Google Search — ceci n’apparaîtra pas dans GSC, mais augmentera vos sessions GA.

| Métrique | Définition | Ce qu’elle mesure | Limites |

|---|---|---|---|

| Session (Google Analytics) | Regroupement d’interactions utilisateur sur une période de 30 minutes ou plus | Engagement sur site, visites multiples, visites répétées | Peut compter plusieurs sessions pour un même utilisateur. Ne différencie pas les sources secondaires dans une session initiale. |

| Clic (Google Search Console) | Nombre de fois qu’un utilisateur clique sur un lien de résultat organique | Origine du trafic à partir de Google Search uniquement | Ne capture que le clic initial, pas le comportement sur site ni retours ultérieurs. |

En somme, la nature même des métriques contribue à l’écart, et cela explique pourquoi SEMrush, Ahrefs, Moz ou ContentKing intègrent souvent ces deux sources dans leurs analyses pour obtenir une vision plus complète.

Facteurs techniques : cookies, JavaScript et ad blockers, leurs impacts sur la mesure du trafic organique

Au-delà des différences de définition, plusieurs aspects techniques peuvent fausser les comparaisons entre GA et GSC.

Cookies : Google Analytics repose souvent sur l’acceptation des cookies pour suivre et attribuer les sessions utilisateur. Le contexte législatif et réglementaire en 2025, avec une adoption généralisée du RGPD, augmente le nombre d’utilisateurs refusant les cookies, ce qui diminue la capacité de GA à mesurer le trafic réel. GSC, elle, n’est pas soumise à ces restrictions car elle est basée sur les données collectées côté serveur Google.

JavaScript : Le script de suivi GA nécessite que le visiteur ait activé JavaScript dans son navigateur. Si celui-ci est désactivé ou si l’implémentation est erronée, aucune session ne sera comptabilisée. GSC ne dépend pas du Javascript car il s’appuie sur le signal donné lors du clic sur le moteur de recherche.

Ad Blockers : Ces extensions, très répandues en 2025, bloquent souvent les requêtes vers Google Analytics, ce qui empêche la collecte de données. Par contre, étant donné que GSC relève directement des serveurs Google, les clics sont enregistrés malgré ces bloqueurs.

- Refus de cookies ou blocage sévère dans la confidentialité peuvent créer une sous-déclaration de sessions dans GA.

- L’absence ou mauvais fonctionnement des scripts JavaScript entraîne des pertes de données dans GA sans influence sur GSC.

- Le trafic bot ou spam parfois détecté comme organique peut fausser les chiffres dans GA mais est souvent filtré dans GSC.

Cette disparité technique explique pourquoi, dans certains scénarios, GSC affiche un trafic plus important qu’Analytics ou inversement. Voici un tableau récapitulatif des principaux facteurs techniques :

| Facteur | Impact sur Google Analytics | Impact sur Google Search Console |

|---|---|---|

| Acceptation des cookies | Sessions manquantes si refusés | Données complètes, pas besoin de cookies |

| Activation JavaScript | Suivi dépendant, pertes possibles | Indépendant, aucun impact |

| Ad Blockers | Blocage fréquent du tracking | Pas d’impact sur les clics comptabilisés |

| Trafic bot | Peut gonfler les sessions si non filtré | Meilleure filtration, clics plus fiables |

La rigueur des audits avec des outils comme Screaming Frog, Yoast SEO ou Majestic permet de détecter et corriger ces erreurs techniques qui biaisent les données.

Configuration et attribution erronée : comment les erreurs de suivi impactent le trafic organique affiché

La mise en place de Google Analytics 4 et Google Search Console ne se fait pas sans risque d’erreurs, et celles-ci peuvent grandement affecter les données affichées.

Un problème fréquent concerne le doublon de taggage sur une même page, pouvant surcomptabiliser les sessions dans GA. C’est souvent le cas lorsque les équipes marketing multiplient les balises ou font des tests de tracking sans désactiver les anciens scripts. De même, des erreurs dans la configuration du cross-domain tracking provoquent parfois des découpages inexacts des sessions.

Les campagnes UTM mal paramétrées représentent une autre cause classique de surévaluation du trafic organique.

- Un paramètre “medium=organic” ajouté par erreur dans des campagnes payantes ou des newsletters augmente artificiellement le trafic organique dans GA.

- Une mauvaise classification des sources conduit à des incohérences.

- Les segments et filtres appliqués dans GA peuvent masquer une partie des données réellement collectées, ce qui fausse la comparaison avec GSC, non segmenté.

Enfin, la gestion multi-domaines joue un rôle majeur. GA4 permet d’agréger le trafic de plusieurs domaines dans une seule propriété, tandis que GSC oblige à gérer des propriétés distinctes pour chaque domaine et sous-domaine. Cette différence entraîne un effet combiné où le trafic global peut apparaître gonflé sur GA par rapport à la vision plus cloisonnée sur GSC.

| Cause | Effet dans Google Analytics | Effet dans Google Search Console |

|---|---|---|

| Balises en double | Sessions multipliées | Pas d’impact direct |

| UTM mal configurés | Trafic mal attribué (ex: organsique sur payé) | N’affecte pas le comptage des clics Google |

| Multi-domaines | Fusions possibles donnant trafic global augmenté | Propriétés séparées, chiffres fragmentés |

| Filtres et segments | Données parfois tronquées ou reclassifiées | Aucun filtrage possible sur rapports |

Pour éviter ces problèmes, il est conseillé de procéder à des audits réguliers avec des solutions comme ContentKing ou SpyFu, et de suivre les bonnes pratiques détaillées notamment sur JDN ou le support officiel de Google Analytics. Ceci garantit des données fiables pour une analyse SEO pertinente.

Comparaison des champs d’application : impact des différents moteurs de recherche sur le trafic organique mesuré

Parler de trafic organique au sens large sans attention aux sources spécifiques peut induire en erreur lorsqu’on confronte GA et GSC. Tandis que Google Search Console est exclusivement centrée sur Google Search, Google Analytics analyse le trafic venant de divers moteurs, un facteur clé à comprendre.

Le trafic organique intégré dans Google Analytics inclut :

- Les sessions venant de Google Search.

- Les visites issues de Bing, un acteur toujours notable en 2025 notamment aux États-Unis et dans certains pays européens.

- Les visites initiées via des moteurs alternatifs comme DuckDuckGo, Yandex ou Naver dans des contextes géographiques spécifiques.

- Les moteurs de recherche spécialisés, parfois sectoriels, notamment présents dans des niches où la concurrence SEO est aiguisée.

Cette extension naturelle des sources organiques dans GA4 relève d’une définition plus globale des visites SEO. En revanche, GSC reste rigoureusement limitée à la plateforme Google, excluant tout trafic organique hors Google, ce qui génère naturellement des nombres inférieurs.

| Outil | Sources incluses dans le trafic organique | Limites |

|---|---|---|

| Google Analytics 4 | Google Search, Bing, DuckDuckGo, Yandex, Naver, autres moteurs alternatifs | Dépend des données collectées par taggage, peut inclure sources mal attribuées |

| Google Search Console | Uniquement Google Search | Pas de données sur autres moteurs, limitation géographique |

C’est la raison pour laquelle il est fondamental, lors d’une analyse, de segmenter les données GA afin d’isoler uniquement le trafic organique issu de Google Search, quand l’objectif est une comparaison stricte avec Google Search Console. Des outils complémentaires comme SEMrush, Moz ou Screaming Frog permettent de valider la présence de trafic significatif sur d’autres moteurs.

Une bonne pratique consiste à exploiter non seulement ces plateformes mais aussi à enrichir les analyses par des solutions qualitatives d’audit SEO afin d’ajuster finement ses stratégies digitales.

L’effet des bots et du trafic spam sur le trafic organique mesuré dans GA et GSC

Avec l’évolution constante des techniques de référencement, la question de la fiabilité des données face aux bots et au trafic spam reste centrale.

Google Analytics peut très facilement enregistrer des visites frauduleuses ou générées par des bots si les filtres adéquats ne sont pas appliqués. Ces visites peuvent se présenter sous forme de sessions nombreuses sur des pages spécifiques, créant un biais dans les données d’entrée. Certaines attaques sophistiquées simulent même un comportement ressemblant à celui d’un utilisateur humain.

Google Search Console, en revanche, méthode basée sur la donnée agrégée de clics authentifiés depuis la recherche Google, filtre efficacement une grande part de ce trafic non légitime. Ainsi :

- GA peut gonfler artificiellement les sessions organiques à cause de bots spécialisés mimeurs de trafic Google Search.

- GSC offre une vision plus épurée des clics organiques, fuyant les doublons et le trafic non-humain.

- Les outils comme Majestic ou SpyFu apportent une couche supplémentaire d’analyse et filtrage pour comprendre la qualité du référencement et détecter le trafic malveillant.

| Source de trafic | Répartition des visites frauduleuses | Capacité de détection | Impact sur les rapports |

|---|---|---|---|

| Google Analytics 4 | Possible présence importante si pas filtré | Modéré à faible sans configuration avancée | Sessions gonflées, fausse interprétation du trafic |

| Google Search Console | Limitée par contrôle Google Search | Élevée grâce au filtrage Google | Rapports plus fiables sur le plan qualitatif |

Un webmaster doit donc veiller à mettre en place des configurations précises dans ses outils d’analyse pour ne pas être trompé par ce type de trafic. Le recours régulier à des audits SEO complets et une surveillance accrue via des solutions expertes comme Screaming Frog ou Yoast SEO s’imposent dans le paysage digital exigeant de 2025.

Les symptômes d’une inflation artificielle et comment la détecter :

- Pics soudains et non corrélés dans Google Analytics mais non visibles dans GSC.

- Sessions avec des durées de visite nulles ou extrêmement faibles.

- Origines géographiques suspectes ou non cohérentes avec votre audience.

Cette vigilance est essentielle pour ne pas tirer de mauvaises conclusions stratégiques.

Utiliser conjointement Google Analytics et Google Search Console pour affiner sa stratégie SEO

Pour appréhender pleinement le trafic organique et éviter les erreurs d’interprétation, il est judicieux de combiner les forces respectives de Google Analytics et Google Search Console.

Ainsi, la double lecture des données permet :

- De croiser les métriques « clics » (GSC) et « sessions » (GA) pour mieux comprendre le comportement post-clic.

- D’identifier d’éventuelles anomalies ou pertes de trafic liées aux facteurs techniques ou aux mauvais paramétrages.

- De segmenter finement les sources de trafic selon les moteurs de recherche, zones géographiques, et supports.

- De perfectionner le suivi des campagnes marketing et SEO, notamment en vérifiant la cohérence des UTMs avec la réalité organique.

- D’optimiser les actions SEO grâce à l’analyse approfondie des requêtes, pages de destination, et taux de rebond combinés.

Pour faciliter cette démarche, des outils comme Yoast SEO et ContentKing offrent des optimisations liées aux contenus et au crawl, tandis que SEMrush et Moz apportent des insights complets sur le positionnement et la concurrence. Screaming Frog permet quant à lui un audit technique approfondi. C’est en multipliant les données issues de sources variées que les professionnels SEO peuvent appréhender les performances de manière globale et stratégique.

| Avantages de l’usage couplé | Bénéfices observés |

|---|---|

| Vision complète du funnel utilisateur | Compréhension des conversions possibles après un clic Google |

| Détection d’anomalies plus rapide | Réactions proactives pour corriger erreurs de tracking et configurations |

| Segmentation affinée | Meilleure personnalisation des campagnes marketing et SEO |

| Optimisation des contenus et UX | Amélioration du référencement naturel et de l’engagement utilisateur |

Les liens suivants fournissent des guides précieux pour approfondir ces notions et paramétrer au mieux vos analyses : Prodiris, LeoFuchs, et Anne Devillers.

Bonnes pratiques pour limiter les écarts entre Google Analytics 4 et Google Search Console

Afin de minimiser les différences entre les chiffres de GA et GSC, certains réflexes et bonnes pratiques sont incontournables dès la mise en place et le suivi :

- Configurer avec précision le tracking GA4 : installer le code une seule fois, vérifier l’absence de doublons et s’assurer que JavaScript fonctionne correctement.

- Ajuster les paramètres de session pour refléter le comportement réel des visiteurs et éviter la division abusive des sessions.

- Segmenter les sources en restreignant le trafic organique à Google lorsque la comparaison avec GSC est l’objectif.

- Éviter les erreurs de paramétrage UTM et former les équipes marketing pour ne pas fausser l’attribution du trafic organique.

- Effectuer des audits réguliers avec des outils comme Screaming Frog, SpyFu ou Majestic afin de détecter les problèmes techniques, le spam et les anomalies de tracking.

- Analyser conjointement GA et GSC pour interpréter les fluctuations de données et améliorer progressivement la fiabilité des rapports.

- Prendre en compte la législation sur les cookies et la confidentialité afin d’adapter les méthodes de collecte et d’être conforme tout en maximisant la qualité des données.

Ces bonnes pratiques sont détaillées dans divers articles spécialisés et formations comme sur le programme Gotch SEO Academy ou les analyses de sites lifestyle sur SEO IA. Elles garantissent une continuité et une cohérence dans le pilotage de vos performances.

La complémentarité des outils SEO professionnels dans l’analyse du trafic organique

Au-delà de GA et GSC, les SEO aguerris s’appuient sur un écosystème d’outils spécialisés pour comprendre, vérifier et enrichir l’analyse du trafic organique. Ces solutions viennent renforcer l’interprétation des rapports et combler les zones d’ombre.

Parmi les outils majeurs :

- SEMrush et Ahrefs pour le suivi des positions, la recherche de mots-clés et la détection des concurrents.

- Moz pour des analyses de domaines et des audits SEO croisés avec des recommandations avancées.

- ContentKing pour le monitoring en temps réel du contenu et la détection rapide des anomalies techniques.

- SpyFu et Majestic pour débusquer les stratégies de liens et évaluer la santé du profil de backlinks.

- Screaming Frog et Yoast SEO pour une approche technique assurant une base saine du site, indispensable avant toute analyse fine des sources de trafic.

Ces outils se complètent parfaitement avec GA et GSC en offrant des perspectives croisées.

| Outil SEO | Usage principal | Apport spécifique dans l’analyse du trafic |

|---|---|---|

| SEMrush | Recherche mots-clés, audit de position | Complète l’attribution organique en détectant sources de trafic non visibles dans GA |

| Ahrefs | Analyse backlinks, contenu | Mesure profondeur SEO et trafic potentiel |

| ContentKing | Monitoring temps réel | Détecte erreurs techniques impactant la mesure du trafic |

| SpyFu | Analyse des stratégies concurrentes | Valide le positionnement et détecte trafic organique caché |

| Screaming Frog | Audit technique SEO | Confirme la qualité des pages suivies par GA |

De plus, des ressources récentes comme Seoptimer approfondissent ces synergies pour maximiser la pertinence des analyses du trafic organique.